- +1

ChatGPT爆火,我們是否可以信任聊天機器人?

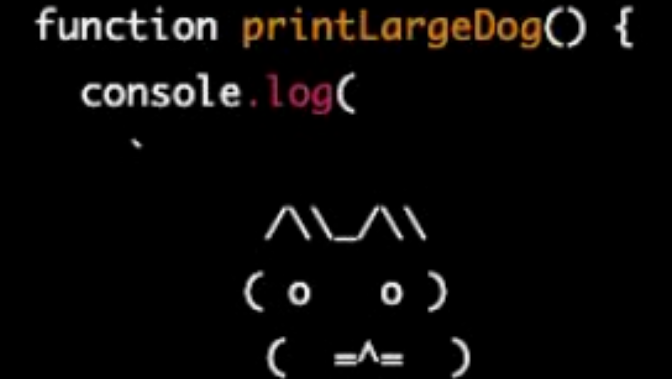

chatGPT生成的程序小狗。

近日,一款名為ChatGPT的聊天機器人火遍全球,該機器人的研發公司OpenAI表示,ChatGPT上線短短5天用戶數量已突破100萬。在網友們曬出的截圖中,ChatGPT不僅能流暢地與人對話,還能寫代碼、找Bug、做海報、寫年報……甚至還以魯迅的文風進行天馬行空的創作,幾乎無所不能。

ChatGPT并非市面上唯一一款對話型人工智能系統。早在去年的I/O開發者大會上,谷歌就演示了專門為對話而建立的LaMDA系統。今年春天,一名谷歌工程師甚至表示LaMDA有自己的“意識”。雖然這一說法遭到了許多人的強烈批評,但卻實實在在地抓住了公眾的想象力。

對話型AI有何玄機?

ChatGPT是人工智能研究實驗室OpenAI在11月30日發布的全新聊天機器人。在OpenAI的官網上,ChatGPT被描述為優化對話的語言模型,是InstructGPT的姐妹模型。這個模型以對話的形式進行互動,使得ChatGPT能夠回答后續問題、承認錯誤、發出質疑并拒絕不適當的請求。

據澎湃新聞此前報道,ChatGPT采用了和InstructGPT一樣的人類反饋中強化學習(RLHF,Reinforcement Learning from Human Feedback)技術,通過將抹去個人信息的人工注釋添加到訓練集之前,利用這些數據來進行模型的微調,達到了提高幫助性和真實性,同時減輕語言模型的危害和偏見的效果。

LaMDA則是谷歌公司在去年5月推出的一款突破性對話應用語言模型技術(The Language Model of Dialogue Applications),谷歌稱其可以參與流動性的自由對話。據《紐約時報》12月12日報道,LaMDA即人工智能研究人員所稱的神經網絡,是一個松散地、仿照大腦中神經元網絡的數學系統。這一技術在谷歌翻譯、自動駕駛等服務中也有使用。

這樣一個神經網絡會通過分析數據來學習技能,例如,通過在數以千計的貓咪照片中找出固定模式,從而學會識別一只貓。

5年前,谷歌和OpenAI等實驗室的研究人員開始設計神經網絡,分析海量的數字文本,包括書籍、維基百科、新聞報道和在線聊天記錄,科學家們將它們稱為“大型語言模型”。該技術可以自動生成文本,并結合不同的概念、模仿人們寫的東西。

通過ChatGPT,OpenAI已經努力完善了這項技術。ChatGPT不像LaMDA那樣能夠進行自由對話,它被設計得更像是Siri、Alexa這類的數字助手。不過與LaMDA一樣,ChatGPT是在從互聯網上摘取的數字文本的海洋中訓練而成的。

聊天機器人并不總說實話

經過海量信息的訓練,ChatGPT這類的聊天機器人能夠很輕易地提供想法、回答問題,但是它們并不總是說實話。它們提供的答案有時真假參半,這導致人們開始擔憂,隨著技術的成熟,這類機器人可能會被利用來傳播假消息和謠言。

一位來自美國弗吉尼亞州的數據科學家亞倫·馬格利斯(Aaron Margolis)告訴《紐約時報》,雖然他時常驚異于LaMDA的開放式對話天賦,但它有時候會“胡編亂造”,因為這是一個被互聯網信息訓練出來的系統。

當馬格利斯要求LaMDA像馬克·吐溫那樣與自己聊天時,LaMDA很快描述了吐溫與李維斯·施特勞斯(Levis Strauss)之間的會面,并說馬克·吐溫在19世紀中期居住在舊金山時曾為李維斯這位牛仔褲大亨工作。這看起來像是真的,但事實是,盡管馬克·吐溫和李維斯同時居住在舊金山,但他們從未一起工作過。

科學家將這種現象稱為“幻覺”——聊天機器人就像一個很會講故事的人,它們有辦法把它們學到的東西重塑成新的東西,但不考慮這些是否真實。

據澎湃新聞此前報道,ChatGPT在釋出不久后就遭到了Stack Overflow(一個程序設計領域的問答網站)的抵制。Stack Overflow暫時禁止用戶分享ChatGPT生成的回復,因為ChatGPT很容易與用戶互動,能夠快速生成大量答案,這讓網站充斥著許多看似可信但不正確的信息。

OpenAI公司也清楚ChatGPT并不完美。該公司警告稱,ChatGPT偶爾可能會“提供不正確的信息”,“產生有害的指令或有偏見的內容”,但OpenAI稱計劃繼續完善該技術,并提醒用戶“這還只是一個研究項目”。

人工智能將去向何方?

谷歌、Meta等眾多科技公司正在著手解決人工智能的準確性問題。Meta公司最近下線了其聊天機器人Galactica的在線預覽功能,因為它反復產生不正確和帶有偏見的信息。

但仍有專家警告稱,科技公司無法掌控這些技術的命運,像ChatGPT、LaMDA和Galactica這樣的系統是基于多年來自由流傳的想法、研究論文和計算機代碼。《紐約時報》11日評論稱,像谷歌和OpenAI這樣的公司可以以比別人更快的速度推動技術的發展,但是他們最新的技術已經被復制和廣泛傳播,他們無法阻止人們利用這些系統來傳播錯誤信息。

ChatGPT上線后,特斯拉CEO埃隆·馬斯克在社交平臺上表示:“我們離強大到危險的AI(人工智能)不遠了”。作為OpenAI公司的創始人之一,馬斯克顯然無限看好這類新技術的發展,但是他也不否認,強大的新技術往往伴隨著危險。

人工智能未來將發展到何種程度尚未可知,但可以確定的是,人工智能的監管與控制問題近在眼前。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業有限公司