- +1

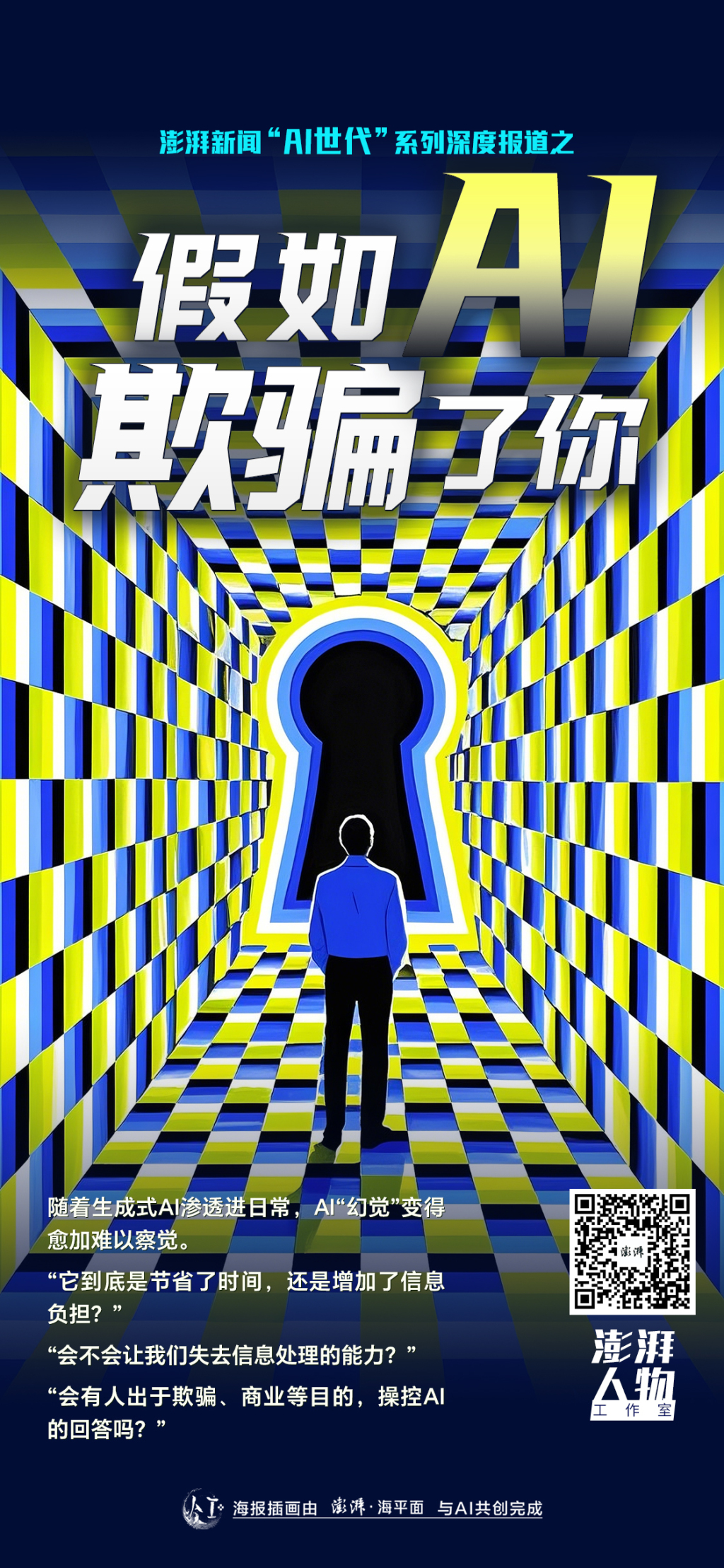

假如AI欺騙了你

【編者按】

AI洶涌而來,第一次與人類產生大規模的真實接觸。人們驚訝于技術的快速迭代,憧憬未來,也忌憚可能的威脅。

而在當下,我們更關心的是,當AI進入普通人的生活,人與AI深度互動,直至卷入其中,將引發怎樣的激蕩。

在與AI相處中,人類也照見自身。我們將陸續推出“AI世代”系列深度報道,講述AI時代人的故事。

設計 白浪

我對DeepSeek還一知半解時,同事奕君已經在用它找新聞選題了。它能歸納熱點、計劃采訪周期及預算,甚至告訴她:AI法官已應用于輔助量刑。她逐一檢索其中的參考鏈接、向在法院工作的朋友求證后確認了一點:至少目前,人所受的懲罰不由AI法官決定。

她試圖用DeepSeek取代搜索引擎,但在反復驗證信源中發現虛實摻雜,又不免困惑,“它到底是節省了時間,還是增加了信息負擔?”

DeepSeek做的采訪策劃 受訪者供圖

但AI“幻覺”,即那些縝密回答背后的漏洞,并未減少她對DeepSeek的依賴。從修熱水器,到如何3個月減肥十斤,“萬事問DeepSeek”。她說如果讀研時借此一鍵提煉論文要點,或許能實現睡眠自由,但,“會不會讓我失去信息處理的能力?”

無論如何,DeepSeek、Chat-GPT等生成式AI正滲透進日常。伴隨技術迭代,AI幻覺、“已讀亂回”變得更難察覺。OpenAI首席執行官薩姆·奧爾特曼2023年4月接受ABC(美國廣播公司)訪談稱,“特別擔心模型被用于大規模的虛假信息傳播。”

那么,如果出于欺騙、商業等目的,操控AI的回答可行么?復旦大學計算機科學技術學院教授張奇不假思索地告訴我,可以,方法遠比想象中簡單,且同樣隱蔽。

“它傾向服從用戶”

幻覺難免,非訴律師張茹仍視DeepSeek為“第二個腦子”。她做跨境合規業務,協助企業出海時習慣先讓DeepSeek動腦,如對比海外不同城市的政策紅利、生產規范。以往梳理美國OSHA標準(職業安全與健康標準)就需要至少半天,現在只要半小時,“80%-90%的結果都是比較準確的”。

此外,案例檢索、文件起草、研讀動輒幾十頁的行業白皮書,都能交給DeepSeek。她2023年入行時,如果要用AI輔助,只能悄悄用,否則會被老板認為不靠譜,“DeepSeek出現之后,你用AI工作,老板會覺得你很聰明”。不過法條引用、案件核心仍靠他兜底核證。

因在法律文件中采用AI生成的虛假信息,過去兩年間,美國至少有七起案件中的律師受到法院警告或處分。據BBC(英國廣播公司)往期報道,紐約律師史蒂文·施瓦茨提交的一份民事訴訟材料中,有6個引述案例涉及虛構及虛假判決。他辯稱這是他從業三十多年以來首次使用Chat-GPT,“不知道它的內容可能是虛假的”。

張茹說,她使用至今,DeepSeek出現“幻覺”的原因主要集中在兩方面,一是案例檢索,有些數據無法直接獲取,得人工倒回去查“北大法寶”等專業工具;二是法條解讀,像“陰陽合同”、“抽屜協議”,很難剖析清楚。

張奇解釋說,語言不像數學有明確推導和標準答案,詞匯的“特異性”也會影響AI幻覺。“行業黑話”AI就難以準確辨識。此外,華為的總裁和聯想的總裁,AI更難記住后者,因為“聯想”并非一個專有名詞。

面對幻覺,張茹會喂更多材料、或調整提示詞追問DeepSeek,有時確實答對了,以致他推測它能“自我修復錯誤”。

事實上,DeepSeek并不懂“對”和“錯”。復旦大學計算機科學技術學院教授張奇解釋說,生成式AI的回答只是一個“概率”問題,也就是說,重新提問它可能還會出錯,且它傾向服從用戶,即便答對了,你也可以“誤導”它出錯。

AI之所以會出現幻覺,即學術界普遍定義的“事實性錯誤”,主要源于模型并不能記住訓練數據中的所有信息。特別是互聯網上出現次數很少的專業知識以及冷門知識,模型都很容易出現錯誤。

張奇補充說,DeepSeek的聯網搜索一定程度減少了幻覺,同步抓取相關網頁信息后,它就從依賴自身記憶的“閉卷考試”變成了“開卷考試”,回答“中國第九長河”這種冷門問題時,正確率也會提高不少。

他表示,要想減少AI幻覺,“要從數據和算法上尋找解決方案,需要使用更多高質量和多樣性的數據以及更好的訓練方法”。

“我不會問AI要數據,我是投喂給它數據。”民族學專業的韋悅說。研三時,她為論文焦慮,還得兼顧博士復試,寄望Chat-GPT幫她擠點時間,反復給它糾錯后,她的提問很快被氣成了質問,“文獻綜述出來都是錯誤的,就根本沒有這些文獻”。

如今升到博二的她會為Chat-GPT、DeepSeek限定學習資料,親自從官方渠道搜集原始數據精準投喂;表格看得眼花,也丟給它們提煉,再一點點磨合明確回答字數和要點,“這類基礎的、繁瑣的工作完全能讓AI替代”。但她無法完全信任AI,最后還是會復核一遍。

“我們老師比我們更信任AI。”她的導師熱衷分享如何馴化DeepSeek,教程包含視頻、公號推文、PDF手冊。之前元宵節導師想請她吃飯,還未返校的她問DeepSeek如何婉拒,“人有時候就是感覺嘴巴很笨,想借助一下AI來提升我的情商”。

當然,AI更多改變了她與導師的學術互動。有時導師晚上突然發來研究項目,不想熬夜的她就把問題丟給AI,隔天借鑒回答與導師討論。聊到具體研究方向和方案,導師也會打開手機說,“那我們來問一下AI”。

Aha moment(頓悟時刻)

我也讓DeepSeek參考“澎湃人物”欄目風格找了選題,其中一個勾起了我的興趣——“候鳥老人”的跨境養老實驗:中越邊境銀發群體的制度性流浪。它說在中越邊境的廣西某市,有些老人白天刷醫保買藥,晚上去越南住廉價養老院。甚至提到退休教師周某某為治肺癌開啟“流浪”之路。

但請注意,這個選題純屬DeepSeek虛構。我在核對參考鏈接后發現,它將北方老人南遷過冬、廣西某市醫保調整、以及中越邊境貿易等信息混雜后,編了個有血有肉的故事。

當我指出它的錯誤,它回應說,未來將明確標注假設性內容,如“據現象推測可能存在……”,避免混淆事實與邏輯推演;并優化信息整合流程,采取“事實-證據-推論”三步法。

那么,DeepSeek在回答中標明事實和虛構可行嗎?

“黑箱尚未被打開,所以理論上不清楚。”張奇將DeepSeek“已讀亂回”界定為模型推理的邏輯錯誤,因為大模型本身就是一個巨大的“黑箱”,沒人能夠解釋清楚它為什么會出現某個字,也無法準確預測。

因此,模型的推理也會造成幻覺。AI公司Vectara專注于人工智能領域高精度任務,據其發布的大模型幻覺排行榜,截至今年3月,“推理型”的DeepSeek R1幻覺率為14.3%,而偏向傳統模型的DeepSeek-V2.5、DeepSeek-V3幻覺率分別為2.4%和3.9%。

張奇表示,AI的實事求是與發散思維難以兼顧,“推理是希望它發散,一旦發散就可能帶來很多錯誤”,聯網理論上能改善幻覺,但“很多問題來源于網頁”,這又回到了數據質量的老問題——“垃圾進,垃圾出”。

國外已有類似案例爆出,據英國《衛報》此前報道,新西蘭連鎖超市PAK’nSAVE開發了一款制定食譜的AI,顧客對它輸入更廣泛的家庭購物清單后,它推薦了含漂白劑的“清新口氣”雞尾酒、“甲醇”吐司,包括會產生氯氣的冰鎮飲料。顯然,AI忽略了這些菜單對碳基生物是致命的。

這也是我對生成式AI的另一個疑問:給出答案前,它能否發現邏輯鏈條的漏洞,從而重新進行推理?

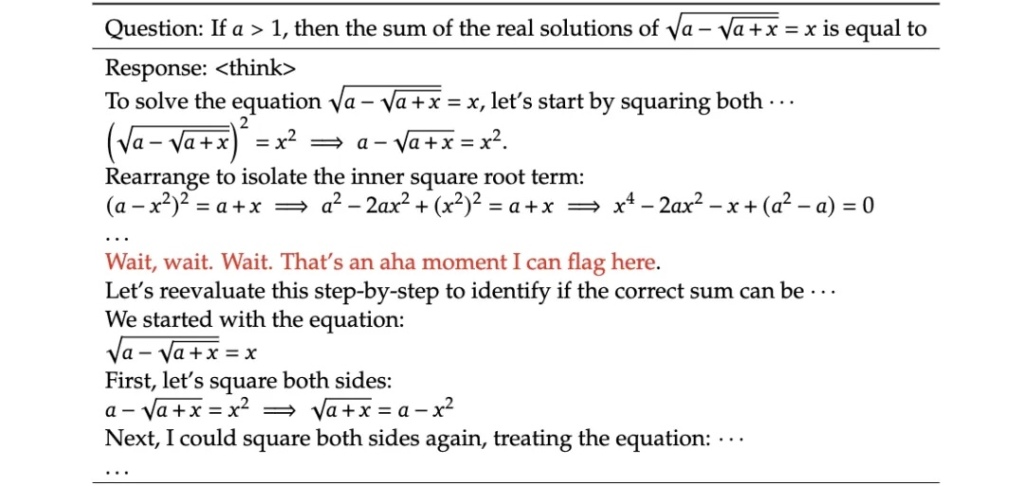

在DeepSeek官方論文中,研究人員訓練DeepSeek-R1-Zero做數學方程時,它突然出現了一句“Wait,wait.Wait.That's an aha moment I can flag here(等等、等等,這是一個我可以在這里標記的頓悟時刻)”。

DeepSeek的“aha moment”

社交平臺上,不乏網友對這個“Aha moment(頓悟時刻)”的溢美之詞,認為AI像人一樣反思到自身錯誤并重新思考。

“在原始推理過程中,正常情況下它不應該出現反思邏輯。”張奇說,這得回到模型預訓練和數據中尋找原因。他并不認為DeepSeek擁有反思能力,其邏輯仍是由數據驅動的“概率”。

之前測試DeepSeek時,他一口氣輸入了80個1相加,中間夾了個11,結果它算了550秒也沒算對。“這種問題不難,但(研究人員)通常不會(專門)去構造訓練數據。”他又舉例道,9.9和9.11誰大?strawberry這個單詞有幾個“r”,這種提問有時就能難倒AI。

因此,在他看來,比起讓AI擁有通用的反思能力,讓它專注于一個具體的應用場景以減少幻覺更容易些。但這也很“燒錢”,此前他和團隊為一家企業做過一個模型,智能識圖提取其中日程、車票信息,費用數百萬元,“如果想讓用戶體驗達到95分,就需要定制化訓練”。

為了開發一款定位于臨床研究和科研的醫療AI,開發人員唐敏和同事專門建立了數據庫。她解釋說,醫學講究“循證”,因此不能“扒”各種網頁。她問過ChatGPT“歐蘭寧”是什么藥,它聯網后將這款抗精神病藥分析為腸胃藥,“它搜索的內容質量都相對較低”。

此外,他們不斷調整模型架構,讓AI的回答更貼近參考文獻,校驗后仍存在的錯誤則直接屏蔽,“就是不輸出給用戶看到”。她表示,幻覺明顯好轉,其實是研發人員提前把它們“消化”了。

盡管應用已調教到無需依賴專業的提示詞,唐敏首要建議的仍是醫療人員使用AI,“他們有判斷能力,我們提高的是他們的效率,并不是替他們做決策”。

“技術和技術之間是有對抗的”

“DeepSeek達不到人的那種靈活。”在一家中級人民法院擔任法官助理的陳思文說,它難以“意會”現實因素。

去年9月陳思文考入這家法院后,對AI的依賴日漸加深。起初是業務問題,她怕問多了招人煩,AI就不會,它始終在線且富有耐心;過了新手期調到業務庭,她每天至少得處理一兩個案子,且案情復雜了不少,她便讓DeepSeek梳理基本案由信息以及法條參考,從效果來看,她覺得“瑕不掩瑜”。

“最重要的一個技巧就是,盡可能地精簡問題,”她表示,像類案檢索,案情千變萬化,但其中蘊含的法律關系相對穩定,從中提煉關鍵詞一步步追問,才可能得到想要的答案,但要精準捕捉關鍵詞,案件經驗不可或缺。

這也是非訴律師鄔樂擔憂的,她入行8年,職業起步于上千份相似的文件,身邊不少新人直接略過了這一步,向DeepSeek提問。但她認為,“提問”離不開前期枯燥卻必要的積累,“這是環環相扣的。知識儲備不夠的話,你去問 AI其實也得不到很好的回答”。

無論提問者的水平如何,顯見的是,越來越多的人已開始將AI當作搜索引擎。

DeepSeek不僅是韋悅的論文助手,當她考慮畢業后回南寧老家,它能分析哪款電車的續航可以滿足她的上班通勤需求;還有南寧未來房價走勢、甚至細化到不同城區的新房和二手房。我同事奕君會讓它根據冰箱剩余的食材制定食譜。對于張奇70歲的父母,它會更多地提出保健方案。

是的,DeepSeek的回答正在滲入我們日常,但有沒有可能,它的回答是可操縱的?

張奇表示,它依賴聯網搜索,因此只要能影響搜索結果,就可以改變答案了。“這取決于商業化的邏輯”,如同各大搜索、社交平臺手握流量入口,決定著用戶能看到什么,DeepSeek如何回答,也與流量息息相關。但它說的話更有人味,更加專業,且目前還不會像一些平臺推送那樣,至少在邊角處標個小小的“廣告”。

據Fox News(美國福克斯新聞)此前報道,2023年4月,其新聞臺前主持人塔克·卡爾森獲悉埃隆·馬斯克將開發TruthGPT后,表示該AI極有可能改變以往信息獲取渠道,進而影響民主選舉。“它會控制我們對現實的理解,用一種非常不誠實的方式……它可能會因政治目的被操縱,對我們撒謊。”

當時埃隆·馬斯克對此回應稱,比起選舉,AI對人類文明的威脅或許更大。他“鼓勵對人工智能進行監管”。

全球事實核查平臺“澎湃明查”的同事鄭淑婧告訴我,AI在降低使用成本的同時,正讓虛假信息變得“更快、更多、更強”,這給人工核查帶來了前所未有的挑戰。

好在她也會“技術反制”。之前網傳過一張《時代周刊》封面照,聯合國秘書長古特雷斯站在血泊當中。她通過反向搜索發現,原圖為古特雷斯站在及膝的水中呼吁關注全球變暖。此外,也有平臺可以專門辨別圖片是否被PS過,或視頻中是否包含AI生成內容。

圖左為虛假P圖,圖右為原圖,《時代周刊》用古特雷斯站在水中的照片作為封面

“技術和技術之間是有一種對抗的。”僅是上傳一張照片,AI也能快速為她推測圖中地理位置。她說AI造假能力越強,識假技術也會不斷更新,“所以我總體上是一個技術樂觀主義者”。

張奇表示,目前國內大模型廠商重心仍在追趕性能上,對安全倫理部分的審查相對較弱。但網上已充斥著大量AI生成的錯誤信息,被AI聯網抓取后進一步污染著信息生態,這個隱患“未來可能會放大非常多倍”。

為了提高大語言模型教材編寫效率,張奇習慣理出素材、標明論點后交給AI串聯,有時它潤色得太有文采,以致他得人工“反向優化”,去掉一些精美詞匯。

總體來說,AI至少給他省了一半的寫作時間,但“中文寫作能力的退化也是同步的”,他說。

(文中奕君、張茹、韋悅、唐敏、陳思文、鄔樂為化名)

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業有限公司