- +1

當AI開始“說謊”:一場人機之間的博弈才剛剛開始

原創 有思想的一刻君 一刻talks

作者 | Talk君

大家好,我是talk君。

最近一段時間,以DeepSeek為首的AI大模型成為了牛馬們手頭不可缺少的輔助工具,但是你是否遇到過這樣的情況?當你向AI提出一個問題,或是讓它協助你撰寫一段文案,幾秒鐘過后,一個看上去內容豐富、邏輯縝密的答案呈現在你面前,可是當你審查時才發現,它竟然是在胡說八道?

這些案例背后,隱藏著一個技術黑話——「AI幻覺」。

啥叫AI幻覺?首先明確下它的定義:

“AI幻覺是指在生成式人工智能模型(如大型語言模型)中,其生成的內容看似合理,但實際上可能與事實不符,甚至完全脫離上下文。這種現象通常表現為生成錯誤、誤導性甚至完全虛構的信息。”

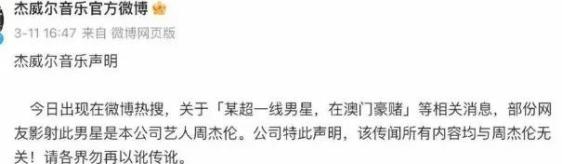

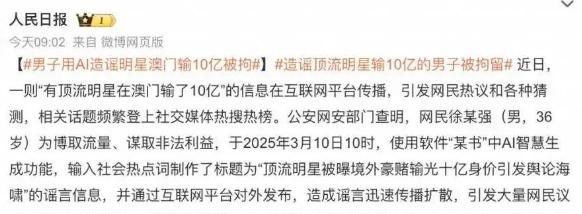

就拿最近的熱點來說吧,前兩天,一條“有頂流明星在澳門輸了10億”的新聞在網絡上引起軒然大波,更是有不少明星出來“自證清白”。

為啥?因為這條消息寫的可太“真實”了,于是網友們紛紛開始猜測事件中的主人公是誰……

但萬萬沒想到,這條新聞竟然是用AI編的假消息。

類似的事件還不在少數,比如前兩天,我需要寫一篇活動新聞稿,我把詳細的素材、重點、要求都喂給AI后,它確實用很快的時間就寫出了一篇新聞稿。

但看過之后發現,其中30%的內容居然是它瞎編的,甚至活動現場沒有出現過的畫面也被它寫了進去。

而更可怕的是,當人工智能越來越完善,那么其自圓其說的能力也會越來越強,屆時,當AI生成錯誤信息形成傳播閉環,并被其他AI當作訓練數據,我們的知識體系將如多米諾骨牌一樣倒下,而我們每個使用者,都可能成為虛假信息的“二傳手”。

AI為什么會產生幻覺?

首先我們可以確定,AI不是要主動欺騙我們,而是它需要用已知的知識來回答我們的問題或是需求,當遇到知識盲區時,它會用自己所理解的方式來完成任務。

這里面,有4個主要原因:

1. 數據偏差:比如訓練數據中可能包含錯誤信息或過時的知識,導致模型學習到不準確的內容。

2. 知識固化:無法動態更新知識,當遇到鮮事物或事件時,他可能會根據舊信息瞎編。(如2025年后政策完全虛構)

3. 算法局限:因為算法的局限性,AI常會生成一些表面看似合理、實則錯誤的推理與建議。特別是在復雜、需要精準判斷的任務中,比如與法律、醫療相關的信息。

4. 幻覺共振:多平臺交叉引用形成"信息繭房",倒逼AI將其誤判為事實。

普通人如何應對「AI幻覺」?

前兩天Manus的創始人肖弘在接受采訪時談到了一個觀點,那就是“有沒有ai都要掌握溯源的能力”。

這里提到的溯源能力非常關鍵,下邊我列舉幾個我平時會用到的方法,基本上能夠應對90%以上的AI幻覺情況。

1. 聯網搜索:現在基本上我們會用到的大模型都有聯網功能,這樣會使AI實時聯網搜索,減少錯誤概率。

2. 文獻提供:當你向AI提完問題或是需求時,不妨在結尾加上一句,“請提供內容對應的文獻或數據支持,信息不明確時請務必注明” ,此時AI給出的答案都會攜帶內容來源,方便你查詢真實性。

3. 雙重檢查:當AI給出答案時,可以將其復制到另一個AI大模型中進行檢查審核。

總之,對于所有AI和互聯網所提供的信息,我們都要進行反復的交叉驗證,這樣的溯源能力,是當代數字公民必要的素養。

「AI幻覺」是否一無是處?

當然,其實「AI幻覺」也并非一無是處,如果你的本意就是要構思一個故事或是進行藝術創作,那有時它的一些“幻想”,還是可以給你帶來眼前一亮的靈感。

對此,你怎么看?你還有哪些方法能夠避免AI“胡說八道”?

歡迎評論區留言討論~

- END -

原標題:《當AI開始"說謊":一場人機之間的博弈才剛剛開始!AI有多會一本正經地胡說八道?》

本文為澎湃號作者或機構在澎湃新聞上傳并發布,僅代表該作者或機構觀點,不代表澎湃新聞的觀點或立場,澎湃新聞僅提供信息發布平臺。申請澎湃號請用電腦訪問http://renzheng.thepaper.cn。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業有限公司