- +1

英偉達下一代Hopper架構GPU來了:H100擁有800億個晶體管

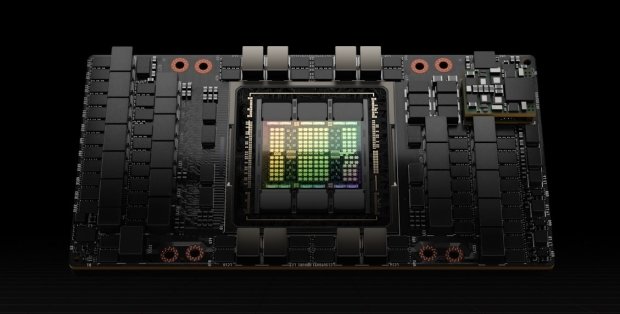

3月22日,在2022 GTC大會上,NVIDIA宣布推出采用Hopper架構的新一代加速計算平臺,其將取代兩年前推出的Ampere架構(NVIDIA迄今為止最成功的GPU架構)。同時,NVIDIA發布了其首款基于Hopper架構的GPU—NVIDIA H100。

NVIDIA H100集成了800億個晶體管,采用臺積電N4工藝,是全球范圍內最大的加速器,擁有Transformer引擎和高度可擴展的NVLink互連技術(最多可連接達256個H100 GPU,相較于上一代采用HDR Quantum InfiniBand網絡,帶寬高出9倍,帶寬速度為900GB/s)等功能,可推動龐大的AI語言模型、深度推薦系統、基因組學和復雜數字孿生的發展。

Hopper架構以“計算機軟件工程第一夫人”Grace Hopper命名。Grace Hopper是計算機科學的先驅之一,發明了世界上第一個編譯器——A-0 系統。1945年,Grace Hopper在 Mark Ⅱ中發現了一只導致機器故障的飛蛾,從此“bug” 和 “debug” (除蟲) 便成為計算機領域的專用詞匯。

NVIDIA表示,H100 GPU在FP16、FP32和FP64計算方面比上一代A100快三倍,在8位浮點數學運算方面快六倍。“對于大型Transformer模型的訓練,H100 將提供高達9倍的性能,過去需要數周時間才能完成的訓練可以減少到幾天內,”NVIDIA產品管理高級總監Paresh Kharya在發布會上表示。

Transformer現在已成為自然語言處理的標準模型方案,也是深度學習模型領域最重要的模型之一。

NVIDIA創始人兼CEO黃仁勛表示,“數據中心正在轉變成‘AI工廠’,它們處理大量數據,以實現智能。NVIDIA H100是全球AI基礎設施的引擎,讓企業能夠利用其實現自身AI業務的加速。”

H100的800億個晶體管采用了專為NVIDIA加速計算需求設計的TSMC 4N工藝,因而能夠顯著提升AI、HPC、顯存帶寬、互連和通信的速度,并能夠實現近5TB/s的外部互聯帶寬。H100是首款支持PCIe 5.0的GPU,也是首款采用HBM3的GPU,可實現3TB/s的顯存帶寬。

據介紹,20個H100 GPU便可承托相當于全球互聯網的流量,使其能夠實時運行數據推理的大型語言模型和推出先進的推薦系統。

H100也是全球首款具有機密計算功能的加速器,可保護AI模型和正在處理的數據。據NVIDIA介紹,客戶還可以將機密計算應用于醫療健康和金融服務等隱私敏感型行業的聯邦學習,也可以應用于共享云基礎設施。

H100采用新的DPX指令可加速動態規劃,適用于包括路徑優化和基因組學在內的一系列算法,與CPU和上一代GPU相比,其速度提升分別可達40倍和7倍。Floyd-Warshall算法(可在動態倉庫環境中為自主機器人車隊尋找最優線路)與Smith-Waterman算法(可用于DNA和蛋白質分類與折疊的序列比對)也在其加速之列。

H100將支持聊天機器人使用功能強大的monolithic Transformer語言模型Megatron 530B,吞吐量比上一代產品高出30倍,同時滿足實時對話式AI所需的次秒級延遲。利用H100,研究人員和開發者能夠訓練龐大的模型,如包含3950億個參數的混合專家模型,訓練速度加速達9倍,將訓練時間從幾周縮短到幾天。

H100可部署于各種數據中心,包括內部私有云、云、混合云和邊緣數據中心,產品預計于今年晚些時候全面發售。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2025 上海東方報業有限公司